最新农业场景 SLAM 数据集 ARD-VO:葡萄园和橄榄园的农业机器人数据集 论文翻译(ChatGPT 机翻 + 人工粗修)

论文题目:ARD‐VO: Agricultural robot data set of vineyards and olive groves

论文作者:Francesco Crocetti | Enrico Bellocchio | Alberto Dionigi | Simone Felicioni | Gabriele Costante | Mario L. Fravolini | Paolo Valigi

发表时间:2023 April 24

DOI: 10.1002/rob.22179

摘要

农业应用中实际数据的可用性对于开发稳健有效的农业机器人解决方案至关重要。然而,在这个应用背景下,研究界很少能够获取到数据集,而对于一些重要的作物,如葡萄和橄榄,几乎没有相关数据集可用。因此,本文旨在介绍和发布一个名为ARD-VO的数据集,该数据集针对葡萄园和橄榄栽培的农业机器人应用。其主要目的是为研究人员提供一个实际广泛的数据集,以支持精准农业技术在上述作物中的解决方案和算法的开发。ARD-VO是通过配备了不同异构传感器的无人地面车辆(UGV)收集的,这些传感器捕获了机器人定位和植物监测任务所需的信息。它由在意大利中部翁布里亚地区的四个种植区中,于2021年8月至10月之间的11个实验会话中收集的序列组成,在这些实验中,UGV行驶了数公里。此外,为了凸显ARD-VO的实用性,本文还提供了两个应用案例研究。在第一个案例中,使用ARD-VO数据集来比较使用视觉系统(vision systems)、光检测(light detection)、测距(ranging)以及惯性测量单元传感器(IMU)进行同时定位与建图(SLAM)和里程计估计方法的性能。第二个案例展示了如何利用 ARD-VO 中包含的多光谱图像来计算归一化差异植被指数图,这对于监测作物和构建处方图非常重要。

关键词:农业机器人、植物监测、机器人数据集

1|简介

随着粮食需求的增加和即将到来的气候挑战,采用精准农业(PA,precision agriculture)解决方案已变得至关重要,它能够优化生产,并有可能减少环境影响。机器人技术在这一转变中发挥着重要作用,自主平台能够大大优化农业活动,减少耗时和危险操作中的人为干预。

在精准农业中,受益于机器人解决方案的最重要方面之一无疑是作物监测。像全地形车(ATV)和无人机这样的机器人平台现在可以配备高吞吐量的嵌入式计算机(带有图形处理单元),这为自动检查和智能农业提供了进一步的可能性(Basri等,2021)。为了填补与人类能力之间的差距,机器人必须利用它们的感知系统来实现两个主要目标:在操作场景中导航并从中收集数据。

为了开发机器人平台的导航和感知模块,农业环境中收集的数据集的可用性至关重要。深度学习技术的出现确实带来了令人瞩目的好处,并开启了以前难以想象的应用。然而,这是以密集的训练为代价的,其有效性严重依赖于领域特定数据集的可用性。此外,更重要的是对于非数据驱动(即基于模型)方法的设计,它们的验证都需要具有代表性的数据,以反映所考虑的场景。

尽管它们如此重要,精确农业(与汽车场景相比)却通常很少有可用的数据集,而且几乎没有为某些特定作物收集的数据集。尽管葡萄园和橄榄栽培在整个农业领域中非常重要,以下是它们的情况:2020/2021季度橄榄产量为3,029,000吨(委员会,2021年),而欧洲出口了14,811,725吨葡萄(欧洲统计局,2020年)。此外,橄榄油和葡萄酒等衍生产品在农业链中代表着重要的经济因素(Palliotti等,2014年;Poni等,2018年)。智能监测和机器人支持代表着保护这些作物的一种新的技术方法。最近的研究表明,智能系统可以轻松地整合到农业流程中,并为葡萄园(Fernández‐Novales等,2021年;Majeed等,2021年;Roure等,2017年)和橄榄作物(Babanatsas等,2018年;Rey等,2019年)带来预期的结果。

基于这些考虑,本研究的目的是收集并向研究界提供一个特定于葡萄园和橄榄作物的数据集,即ARD-VO,以改善用于导航和监测应用的稳健有效的机器人系统的开发。数据采集是通过使用真实的机器人平台进行的,并旨在嵌入与农业环境相关的信息和挑战。机器人传感器设置可以提供多个信息源,对于不同的研究领域至关重要,包括同时定位和建图(SLAM)算法、机器人状态的预测分析以及特定的农业研究,如归一化差异植被指数(NDVI)分析(Carlson和Ripley,1997年;Carter,1994年;Matese和Di Gennaro,2021年)。ARD-VO由超过1 TB的数据组成,这些数据是在大约10小时的导航会话中收集的,行驶了数公里。数据来自八个异构传感器,并在四个不同的种植区域进行了采集。

本论文的组织结构如下所示。在第2节中,对最近和相关的研究进行了调查。然后在第3节中描述了机器人平台Agrobot及其设备。如第4节所述,这个机器人被用于在不同的农作物中记录原始数据。然后,根据第5节的描述,对这些信息进行处理、组织和打包。本文还在第6节中介绍和讨论了展示ARD-VO实用性的两个应用研究。在第7节中,我们总结了结论和未来工作。

2|近期研究

尽管针对室内或城市户外场景存在不同的公开可用的定位和建图数据集,但针对农业环境中的自主机器人任务的数据集较少。已经可用的数据集主要侧重于监测和精准农业任务(Y. Lu和Young,2020年),例如作物/杂草辨别、植物表型学、叶片检测、冠层体积计算(Potena等,2020年)、水果计数(Bellocchio等,2020年)和产量估算(Bellocchio等,2022年)等。

2.1|农业植物监测数据集

在过去的几年里,出现的大多数与农业相关的数据集都专注于植物监测。它们通常由使用RGB相机和多光谱传感器收集的图像组成。这些数据集的最常见应用包括杂草控制、害虫监测(Lippi等,2021年)和水果检测。

杂草控制数据集是使用无人地面车辆(Haug和Ostermann,2014年)或无人机(Sa等,2018年)、手持传感器(Lameski等,2017年)或地面固定平台(Leminen Madsen等,2020年)收集的。这些数据集通常用于训练语义分割模型,如果报告的注释是像素级的(Haug和Ostermann,2014年),或者用于目标检测策略,如果注释由边界框组成(Leminen Madsen等,2020年)(这允许区分种植区域和杂草)。

水果检测数据集用于训练目标检测或语义/实例分割模型,能够在图像中检测和计数水果。特别是,它们通常由描绘植物冠层及其上的水果的图像组成,这些图像是使用远程操作平台(Bargoti和Underwood,2017年;Bellocchio等,2019年)或手持传感器(Häni等,2020年)收集的。每个图像使用边界框或像素级的真实标注进行注释,报告了水果的位置和感兴趣区域。

农业相关数据集的较少见的应用包括树木修剪(Akbar等,2016年)、花朵检测(Dias等,2018年;Kusumam等,2016年)以及植物疾病或损伤的检测(Alencastre-Miranda等,2018年)。在Y. Lu和Young(2020年)中,详细介绍了公开可用的用于精准农业计算机视觉任务的数据集的调查。

2.2|机器人定位和测绘数据集

在本节中,我们根据环境背景(城市和乡村场景)对用于机器人定位和导航目的的最流行的公开可用数据集进行概述。

2.2.1|城市场景数据集

对于机器人定位,有几个常见的数据集涉及室内(例如建筑物)和室外(例如城市街道)环境。室内数据集的大部分是在工业建筑物(Burri等,2016年)或办公室(Klenk等,2021年)中使用手持式传感器套件、背包上安装的传感器(Wen等,2019年)或无人机平台(Shi等,2020年)进行收集的。室外城市数据集通常是使用传感器化的汽车(Blanco-Claraco等,2014年;Choi等,2018年;Geiger等,2013年;Kim等,2020年)或轮式机器人(Smith等,2009年)进行收集的。在过去的几年中,对使用虚拟城市环境构建的数据集也越来越感兴趣(Cabon等,2020年;Gaidon等,2016年)。虚拟环境的主要优点是可以在不进行真实世界实验的成本和风险的情况下收集新的数据序列。

2.2.2|农村场景数据集

Aguiar等人(2020年)对农村环境中机器人应用进行了全面的调查。该研究考察了农业和森林环境中地面机器人的定位和建图技术的最新进展,包括SLAM和视觉测距(VO)方法。研究强调了在周围环境条件恶劣的情况下(缺乏结构化对象、重复的场景、反射、崎岖的地形和根据季节和天气条件变化的植被外观)获得适当的传感器系统(自感知和外感知)的挑战和重要性。这些都代表着重要的设计约束(硬件和软件)。此外,该调查还回顾了可以用于在户外环境中测试和研究SLAM和VO算法性能的不同数据集。在其中,我们认为与我们的数据集最相关的是Pire等人(2019年)和Chebrolu等人(2017年)提出的数据集。Rosario数据集(Pire等人,2019年)是在大豆田中使用无人地面车辆(UGV)进行收集的,该车辆专为除草而设计。该数据集由六个序列组成,包含了在车辆在田间行驶时记录的轮子测距、惯性测量单元(IMU)、立体相机和全球定位系统实时动态解(GPS-RTK)系统的同步测量。类似地,BoniRob(Chebrolu等人,2017年)数据集是在甜菜田中使用由博世DeepField Robotics开发的多功能UGV收集的,旨在区分作物和杂草。在这个数据集中,数据在2016年春季的3个月内每周记录三次。每个序列包含来自不同传感器的数据:带RTK的Leika和Ublox GPS、Velodyne光检测与测距(LIDAR)、Kinect和JAI相机以及FX8相机。尽管上述数据集的序列是在草本作物内收集的,我们提出的数据集是在两种基本不同的乔木种植环境中收集的。

在农村场景中,用于定位和障碍物检测目的的其他相关数据集是在没有机器人平台的情况下收集的,例如Kragh等人(2017年)和Ali等人(2020年)。在Kragh等人(2017年)中,作者们提出了一个用于农业场景中障碍物检测的数据集,该数据集是在丹麦的草坪割草场景中使用挂载在拖拉机上的传感器系统收集的。获得的序列由立体相机、热像仪、网络摄像头、全景相机、激光雷达、雷达、惯性测量单元(IMU)和全球导航卫星系统(GNSS)收集的2小时数据组成。所有的静态和移动障碍物都标有对象类信息和地理坐标。在Ali等人(2020年)中,作者们提出了一个用于森林景观中视觉SLAM评估的数据集,该数据集是使用安装在基于四个RGB相机、一个IMU和一个GNSS接收器的车辆上的传感器装置收集的。该数据集由12个序列组成,这些序列是在不同季节和不同时间驾驶车辆通过森林的道路上收集的。

尽管这些数据集无疑为设计和比较定位和建图策略提供了有用的基础,但它们并没有涵盖机器人在农田中工作的应用场景。受Aguiar等人(2020年)的启发,并与以往的工作不同,我们在葡萄园和橄榄栽培地使用机器人平台收集了一个数据集,旨在为研究人员提供一个基准,以便更好地分析与这些农村环境相关的挑战,特别是在开发有效的导航算法和分析农业特定信息(例如多光谱图像)方面。

2.3|贡献

所有上述的数据集都是在室内建筑、城市场景或以草本作物为特征的农村环境中收集的。据我们所知,我们提出的数据集是第一个在与橄榄栽培和葡萄园相关的非结构化户外场景中收集的数据集。本研究的主要贡献总结如下:

- 我们提出了一个在两种不同的乔木作物场景中收集的农村户外非结构化环境的数据集。具体而言,ARD-VO包括在不同的葡萄园和橄榄栽培地收集的序列。这些序列包括使用立体相机装置、Velodyne激光雷达、带有IMU的GPS-RTK模块和多光谱相机收集的数据。同时,还收集了逆变器状态,提供了有关机器人电机运行的附加信息。以下章节将详细描述数据采集活动和数据集结构。

- 我们提供了对专门设计用于在非结构化的户外种植环境中进行自主植物监测的UGV进行了详细的技术描述。UGV的描述包括平台上安装的所有传感器的列表、机器人结构的细节以及电气设备的规格说明。

- 实验部分展示了所提出的数据集的两个应用案例,即基于激光雷达和基于视觉的定位方法之间的基准比较,以及地理参考的归一化差异植被指数(NDVI)图的计算。

3|机器人平台

在农业中,传统的农机(如拖拉机和收割机)和机器人平台共享相同的工作条件:具有挑战性和多样化的环境。葡萄园和橄榄树林通常位于通常不难到达的地形上(必须保证收获过程),但存在不可预测的情况,例如带有巨石的不平地表、陡峭的斜坡和正/负障碍物(如凸起和洞口)。除了这些不可靠的表面之外,天气在保持抓地力和牵引力(例如雨后的泥泞或其他滑动条件)方面可能发挥着关键作用。在设计我们用于收集数据集的机器人平台Agrobot时,考虑到了这些方面。下面将介绍该平台,并提供有关其结构、传感器和机载计算机单元的详细信息。

3.1|机器人结构

机器人的上部设计旨在方便设备的部署。图1显示了Agrobot平台的简化方案,并提供了相应的主要尺寸表。具体而言,三个扁平的表面使得外部传感器的位置灵活,而梯形轮廓则保证了充足的内部空间以适应机载电子设备。底盘的下部容纳了电池仓和推进马达。Agrobot被设计为四轮滑移转向移动机器人,这是一种常用于全地形车的运动学配置(Campion等,1996年;Kozłowski和Pazderski,2004年)。该配置的主要优点是机械系统的简单性和稳健性(即无需额外的转向系统)以及高机动性。与Ackermann转向模型(Carpio等,2020年;King-Hele,2002年)相比,滑移转向运动学理论上提供了零转弯半径。即使是使用轮子,Agrobot的操作方式也类似于履带车辆:左右两侧等效速度之间的差异会导致车体的旋转运动。每个轮子都与一个80:1的传动比的运动链连接,配备了一个2千瓦的三相无刷直流电机,可达到4300转/分钟和4.6牛米的扭矩。两个双通道的逆变器确保机器人的每一侧轮子具有相同的角速度(否则,滑移转向将无法实现)。

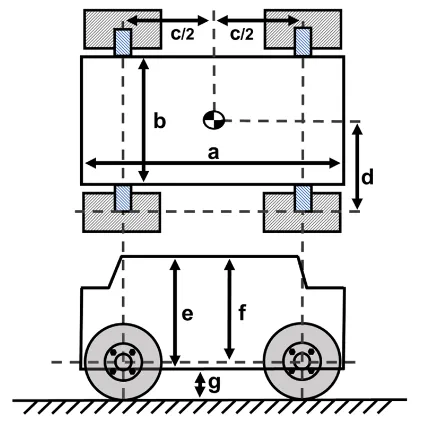

图1 机器人平台的俯视图和侧视图,标注了主要形状和位置尺寸

表1 图1中的形状、位置尺寸

| 变量 | 值 |

|---|---|

| a | 1.30(m) |

| b | 0.77(m) |

| c | 0.80(m) |

| d | 0.20(m) |

| e | 0.77(m) |

| f | 0.74(m) |

| g* | ≈0.24(m) |

| Weight** | ≈700(kg) |

| Genial Tyre Agri Line轮胎 | 6.5∕80 R13 |

离地间隙(g)是在一个平坦的表面上评估的,并且可能会根据表面条件而改变。机器人的整备重量(Weight*)是指正常工作状态下的重量(包括所有设备、传感器和进行操作所需的物品)。

3.2|传感器设备

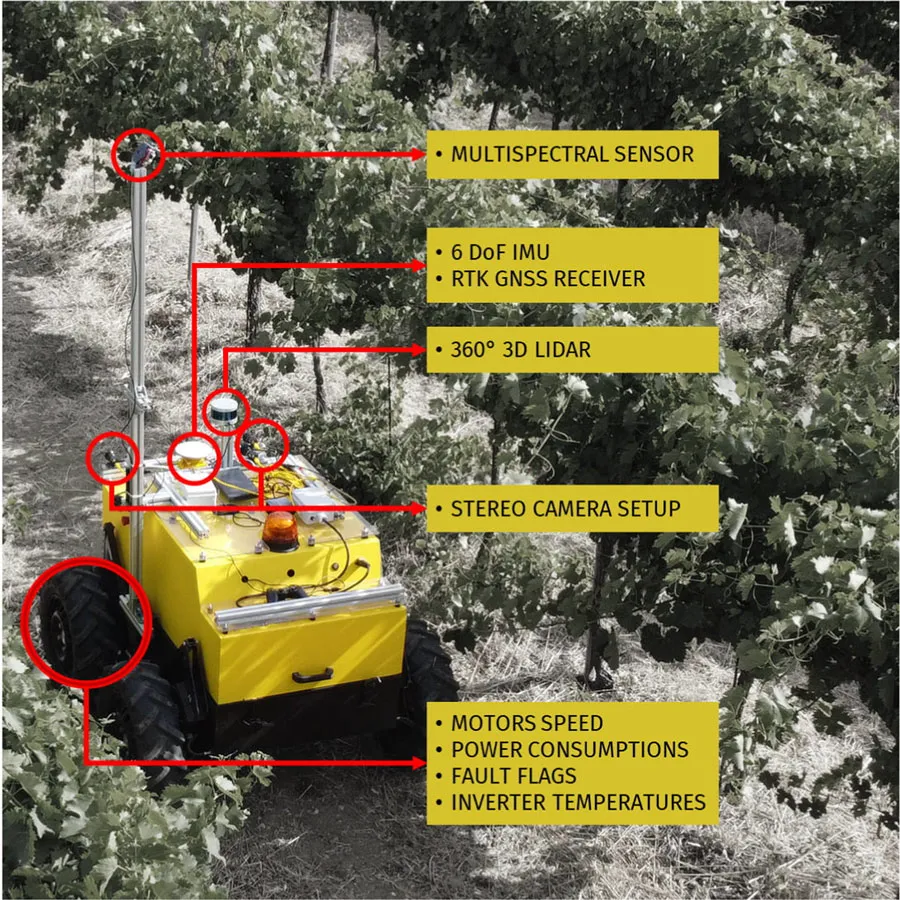

在图2中,展示了Agrobot实验设置的概览。对于导航任务至关重要的外部传感器(例如摄像头、GPS和IMU)已固定在机器人车身上,采用聚碳酸酯板和防振支架来减少高频噪声。这种安排保证了视觉遮挡最小,并且相对于机器人的整体而言具有最佳的视场(FoV)。

图2 在葡萄园领域的数据采集过程中,Agrobot的后视图;红圈突出显示了外部和内部传感器。3D表示三维;DoF表示自由度;GNSS表示全球导航卫星系统;IMU表示惯性测量单元;LIDAR表示光探测和测距;RTK表示实时动态定位

为了延长电子设备的寿命,传动系统和处理单元已经安装在机器人内部,采用了相同的防振策略。由于采用了全电动推进和专用通信总线(CAN总线),可以直接从逆变器中获取所有电机信号。接下来,对传感器设备进行简要描述。

- 多光谱相机:我们使用了一台RedEdge MX相机。该模块拍摄五幅不同的图像,对应于蓝色475(32)、绿色560(27)、红色668(14)、红边717(12)和近红外842(57)波段,分辨率固定为1280×960像素,采样频率为1赫兹。该设备的主要优点是每组图像的带宽较窄:它不是使用一个宽带成像器和一组阻挡滤光片,而是嵌入了五个经过优化的成像器及其传感器和滤光片。相机模块还配备了一个独立的外部GPS用于对图像进行地理标记。

- 实时激光雷达(LIDAR):机器人配备了Velodyne Puck LITE激光雷达,可在100米范围内提供360°水平扫描,并具有垂直FoV为30°的16个通道。这些特性使得该设备适用于农业场景。其他相关参数包括每秒的点数(高达600,000个)和角分辨率(2.0°垂直和0.1° - 0.4°水平)。该设备通过100 Mbps以太网连接与机器人连接,并通过用户数据报协议(UDP)协议发送测量数据。如图2所示,Puck LITE扫描仪通过垂直支架(20厘米)连接到机器人上,以防止机器人底盘产生阴影。

- 惯性和位置测量单元:机器人上安装了两个不同的GPS-RTK单元:Duro Inertial和CL55控制单元,分别由Swiftnav和Infomobility SRL制造。Duro设备支持GPS L1/L2、GLONASS G1/G2、BeiDou B1/B2和Galileo E1/E5定位系统,以及基于卫星的增强系统,可以以10 Hz的刷新率进行定位测量,水平和垂直精度分别为1 cm +1 ppm和1.5 cm +1 ppm。它还配备了集成的6自由度IMU模块(Bosch BMI160),可选择10至200 Hz之间的数据速率。CL55单元是一种实验性的、正在开发中的设备,已配置为与Duro设备相同的刷新率(10 Hz)一起使用,并且被配置为与Galileo配合工作。

- 相机装置:机器人配备了双目摄像头装置。机器人的前部安装有一块Bosch Rexroth型材,配置有两个Blackfly S BFS-PGE-04S2C-C相机,配备有一枚4毫米FIFO镜头。相机的最高拍摄速率为每秒350帧(FPS),分辨率为720×540(0.4百万像素)。双目摄像头的基线为0.62米。另一个由Infomobility SRL提供的实验性双目摄像头模块携带有两个35毫米的黑白相机,最大可以以每秒60帧的速率捕捉1280×1024像素的图像,基线为0.125米。

- 电机逆变器:我们使用了两个ROBOTEQ HBL2360A作为三相高功率电机逆变器。它们能够以高达75安培的电流驱动无刷直流电机。每个电机都有三个霍尔效应传感器,逆变器使用这些传感器来识别转子位置并进行调制。逆变器通过500 kbit/s的CAN总线与中央计算机进行通信,以每秒10次的频率提供电机瞬时功率消耗(瓦特[W]和安培[A]),电机转速(转每分钟[RPM]),逆变器温度(摄氏度[°C])以及诊断故障标志(整数值)的电气测量数据。

3.3|车载计算机和嵌入式控制单元

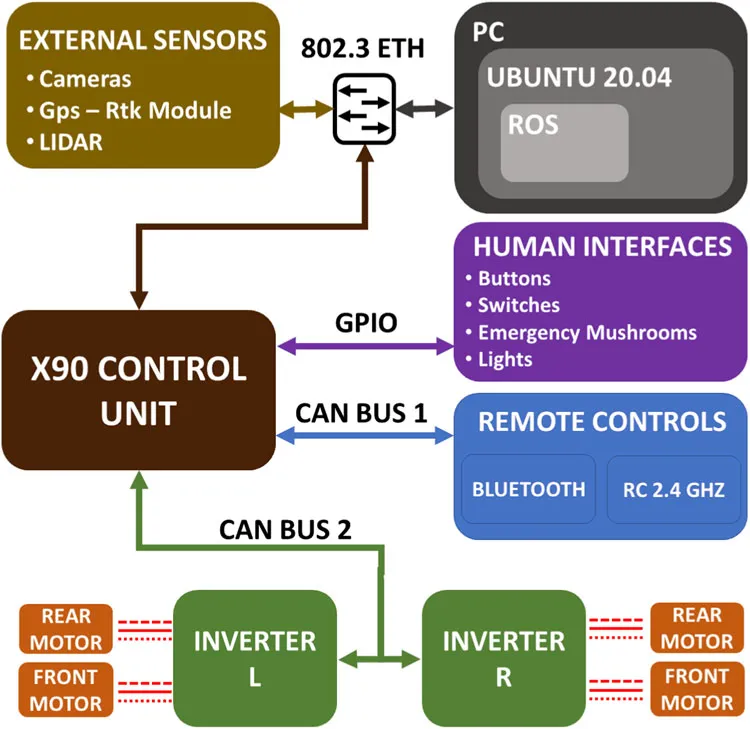

Agrobot架构的框图如图3所示。具体而言,电机逆变器、人机界面和远程操作模块(RC和蓝牙收发器)连接到B&R X90控制单元。X90充当级别1的监控控制与数据采集PLC控制器(Boyer,2009),处理物理设备的连接(即通过通用输入输出端口和CANopen总线)并向更高级别的计算机提供功能。X90编码以使用以太网/IP协议(Brooks,2001)与监控计算机通信:传输控制协议和UDP数据包传输数据和高级控制信号,使用OPC-UA标准(Leitner和Mahnke,2006)。监控计算机是由C&T Solution制造的无风扇嵌入式系统。该设备设计用于在机械和环境应力(宽温范围和高频振动)下工作。PC外壳中没有通风孔,提供更强的隔离性,防止灰尘、水和泥浆进入。

图3 系统框图:机载计算机通过以太网协议与外部传感器和X90控制单元相连,作为机器人内置设备的接口。CAN,控制器局域网;ETH,以太网;GPIO,通用输入输出;GPS,全球定位系统;LIDAR,光检测与测距;PC,个人电脑;RC,遥控;ROS,机器人操作系统

该系统直接由机器人的电池供电,并嵌入了自定义主板,配备了Intel i7-9700E中央处理器和NVIDIA GeForce RTX 2060。两个SODIMM插槽配备了32 GB DDR4 2666 MHz的随机存取存储器。我们决定安装两种不同的存储系统:一个PCI Express ×4 NVMe 1.3,256 GB用于操作系统(Ubuntu 20.04 LTS 64位),以及两个SATA SSD 2.5英寸,2TB的数据磁盘。这两种存储解决方案都具有广泛的温度范围操作性:-45°C/+85°C。

4|数据集的采集

Agrobot平台被用于在意大利中部的翁布里亚地区的葡萄园和橄榄田中获取数据。数据集中报告了数据集的别名、作物品种和位置等,详见表2。图4a、b显示的两个葡萄园,图4c、d显示的两个橄榄田被选为记录活动的目标。

表2 数据集采集地信息

| 别名 | 作物品种 | 经度(N),纬度(E) | # 会话 | 日期 |

|---|---|---|---|---|

| Vynrd A | Grechetto Todi G5 | 43.004491, 12.294889 | 1 | 2021 年 9 月 3 日 |

| Vynrd B | Grechetto Todi G5 | 42.812355, 12.418741 | 2 | 2021 年 8 月 4 日;2021 年 9 月 1 日 |

| OlvCs A | Moraiolo | 42.967206, 12.407057 | 4 | 2021年9月14-23-30日;2021年10月13日 |

| OlvCs B | Moraiolo, Leccino, Frantoiano | 42.961702, 12.412744 | 4 | 2021 年 9 月 14-23-30 日;2021 年 10 月 13 日 |

图4 这项工作的数据集采集地及其别名:(a,b)葡萄园和(c,d)橄榄作物。 (a) Vynrd A、(b) Vynrd B、(c) OlvCs A 和 (d) OlvCs B

根据表2所示,数据采集活动在2021年夏季至秋季期间进行,从8月到10月。为了保证记录的数据在农业和导航分析方面的可靠性,机器人以平均速度1米/秒手动驾驶。在葡萄园中,每个采集会话的平均行驶距离约为8000米,而在橄榄林中,轨迹长度在400到1000米之间。

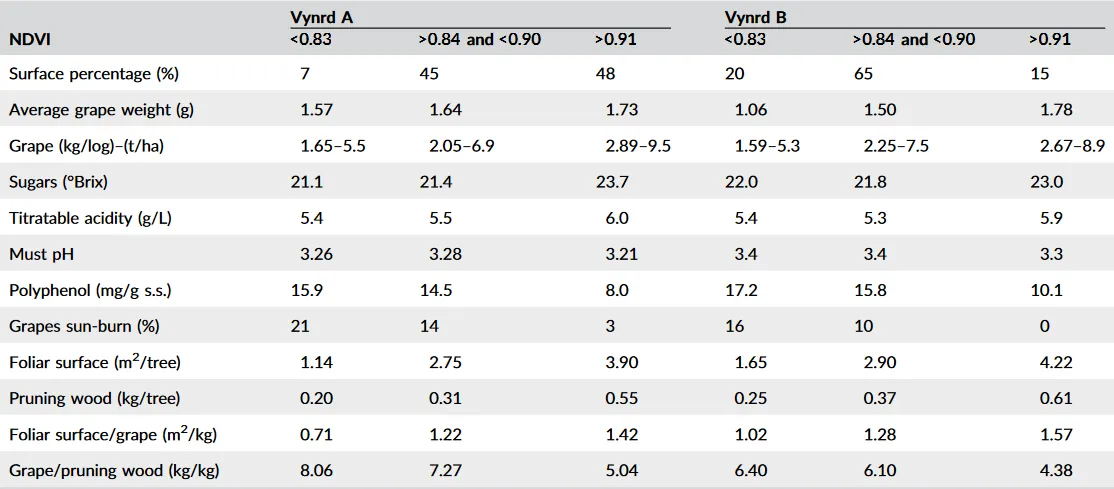

表3显示了我们在每个采集会话日期(2021年9月14日至10月13日之间)对橄榄树生长阶段的描述。生长阶段是根据国际Biologische Bundesanstalt,Bundessortenamt und CHemische industrie刻度(Sanz-Cortés et al.,2002)来表达的,该刻度描述了从芽发育(0)到衰老(92)的橄榄树的表型发育。此外,在表4中,我们报告了葡萄园的产量特征和植被-生产平衡指数的信息。这些值是通过在作物的不同区域进行手工检查获得的。具体而言,我们根据该位置计算得出的NDVI指数(有关NDVI地图计算的描述,请参见第6.2节)对这些值进行了分组。

表3 基于 BBCH 尺度的橄榄树生长阶段(Sanz-Cortés 等,2002)时间:dd/mm/yy

| 作物 | 14/09/21 | 23/09/21 | 30/09/21 | 13/10/21 |

|---|---|---|---|---|

| OlvCs A | 80 | 80 | 85 | 89 |

| OlvCs B | 80 | 81 | 85 | 89 |

注:80和81左右的值表示果实开始着色,85表示特定着色的增加,而89表示最佳采收阶段(即适合榨油,当果实达到典型颜色但仍保持膨润时)

缩写:BBCH: Biologische Bundesanstalt, Bundessortenamt und CHemische industrie

表4 不同NDVI分区的葡萄园生产特征及营养-生产平衡指数,即低活力(NDVI<0.83)、中活力(0.84<NDVI<0.90)和高活力(NDVI>0.91)

*P.S. 与我的工作不相关,也不太懂,这个表格就不翻译了*注:这些值是通过对作物不同区域进行手动检查计算得出的

缩写:NDVI,Normalized Difference Vegetation Index

包含在ARD-VO数据集中的采集序列来自第3节列出的传感器子集。具体而言,我们考虑了两个前置摄像头、Swiftanv Duro Inertial套件的GPS-RTK和IMU、RedEgde MX多光谱摄像头、Velodyne激光扫描仪和两个逆变器。

5|数据集

本节描述了提议的数据集的内容和特点。对于表2中列出的每个会话,可获得两组数据:第一组是使用连接到机载计算机的传感器生成的,第二组仅使用多光谱相机生成,其流通过使用RedEdge Micasese套件的GPS进行独立地标记。对于每个会话,我们使用机器人操作系统(ROS)(Quigley等,2009)来处理与直接连接到机载单元的设备相关的数据,而多光谱图像则直接存储在RedEdge相机的固态驱动器(SSD)存储器中。由于会话的持续时间可能在1到2小时之间变化,因此每个会话被分为若干较短的序列。在接下来的章节中,我们对这些数据集的内容进行了简要描述。图5显示了一组RGB图像和激光扫描的示例。

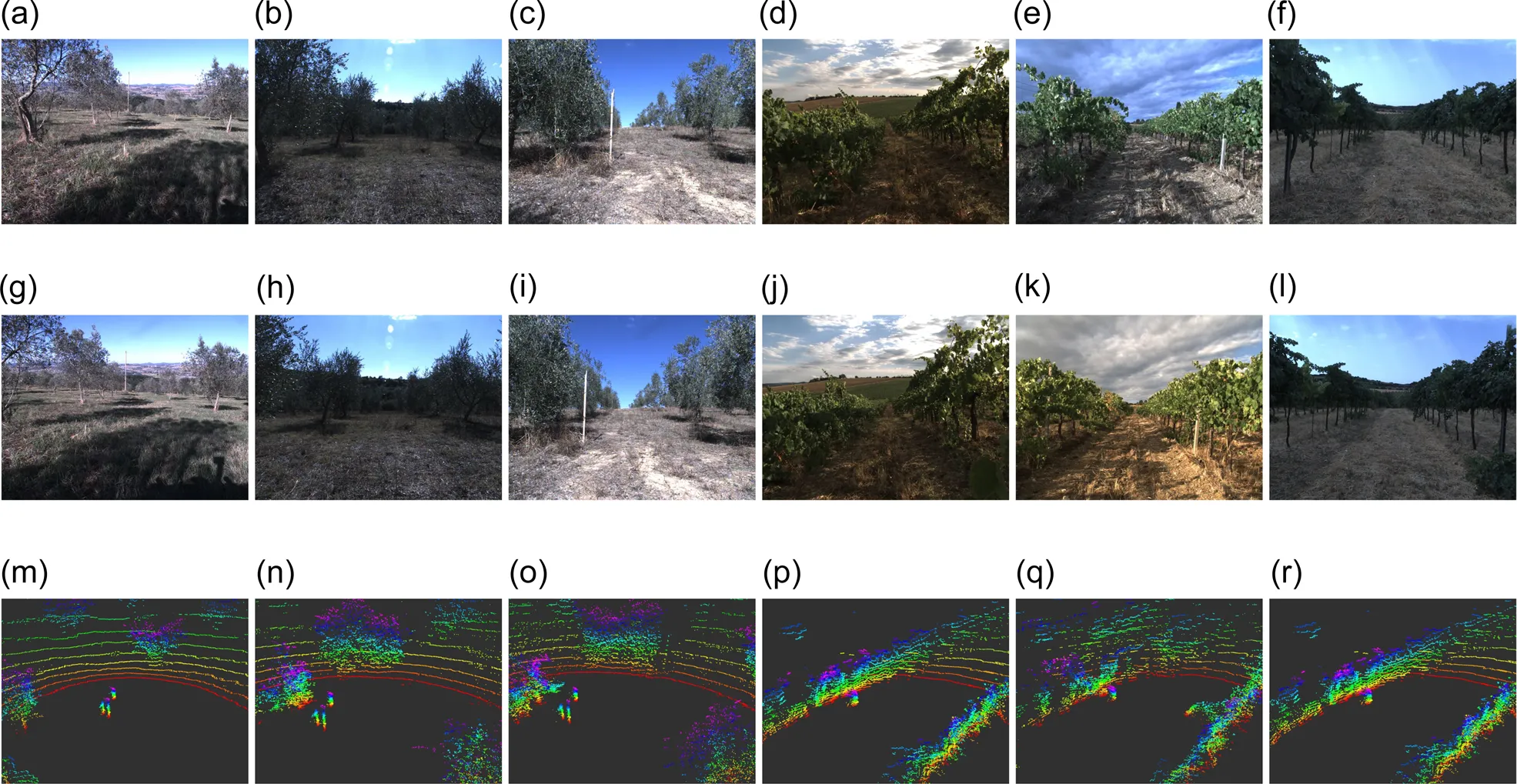

图5 第一行和第二行包含双目左侧(a-f)和双目右侧(g-l)相机收集的RGB图像。第三行包括激光扫描的示例。前三列(a-c,g-i,m-o)包含从橄榄农田收集的序列样本,而后三列(d-f,j-l,p-r)包含从葡萄园收集的样本。(a) OlvCs A-1,(b) OlvCs B-1,(c) OlvCs B-2,(d) Vynrd A-1,(e) Vynrd A-2,(f) Vynrd B-1,(g) OlvCs A-1,(h) OlvCs B-1,(i) OlvCs B-2,(j) Vynrd A-1,(k) Vynrd A-2,(l) Vynrd B-1,(m) OlvCs A-1,(n) OlvCs B-1,(o) OlvCs B-2,(p) Vynrd A-1,(q) Vynrd A-2,和 (r) Vynrd B-1.

5.1|传感器标定参数

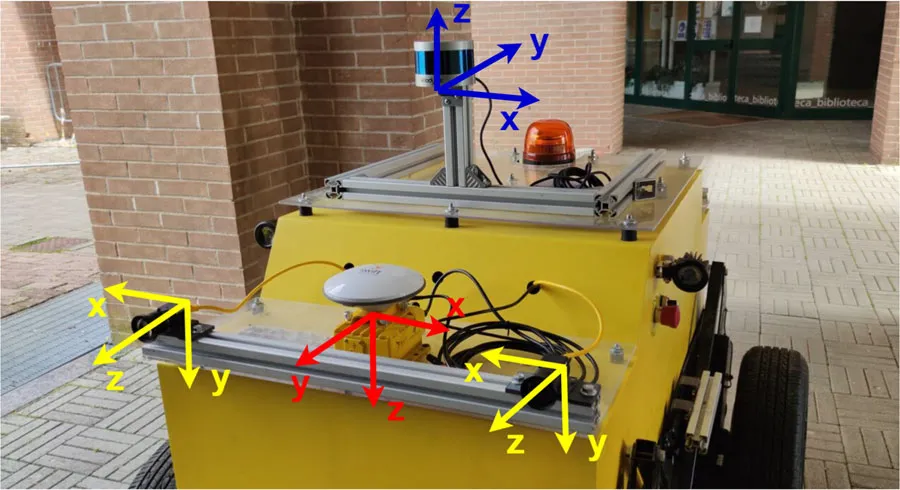

各种传感器的外部和内部标定参数总结在表5和表6中。在线数据集还包括包含相机、IMU和LIDAR标定参数以及所有传感器之间的转换的完整标定文件。双目左侧(即cam0)和双目右侧(即cam1)相机以及IMU通过kalibr(Furgale等人,2012年,2013年; Maye等人,2013年)工具包进行校准。对于相机,使用针孔相机模型和径向切向畸变进行校准。 IMU噪声模型由加速度计噪声密度(连续时间)$σ_a$、加速度计随机漂移$σ_{ba}$、陀螺仪噪声密度(连续时间)$σ_g$、陀螺仪随机漂移$σ_{bg}$和采样率(Hz)来描述。这些参数的值在表5中报告。我们还使用kalibr工具来估计立体外部参数和IMU与相机之间的相对变换。对于LIDAR-IMU之间的变换,我们测量了传感器之间的相对距离和方向。在图6中显示了安装在机器人上的LIDAR和IMU的坐标系。最后,相关的相对变换在表6中报告。

表5 相机和IMU的标定参数

| 相机内参 | cam0 | cam1 |

|---|---|---|

| $w$ | 720 | 720 |

| $h$ | 540 | 540 |

| $f_u$ | 511.047 | 499.235 |

| $f_v$ | 508.925 | 499.163 |

| $p_u$ | 359.324 | 371.222 |

| $p_v$ | 281.585 | 283.716 |

| $k_1$ | −0.07229 | −0.07055 |

| $k_2$ | 0.04879 | 0.03647 |

| $r_1$ | 0.00232 | 0.00089 |

| $r_2$ | −0.00246 | 0.00004 |

| IMU参数 | 单位 | 值 |

|---|---|---|

| $σ_{a}$ | $\left(\frac{\mathrm{m}}{\mathrm{s}^{2}} \frac{1}{\sqrt{\mathrm{Hz}}}\right)$ | 0.08 |

| $σ_{ba}$ | $\left(\frac{\mathrm{m}}{\mathrm{s}^{3}} \frac{1}{\sqrt{\mathrm{Hz}}}\right)$ | 0.008 |

| $σ_{g}$ | $\left(\frac{\mathrm{rad}}{\mathrm{s}} \frac{1}{\sqrt{\mathrm{Hz}}}\right)$ | 0.002 |

| $σ_{bg}$ | $\left(\frac{\mathrm{rad}}{\mathrm{s}^{2}} \frac{1}{\sqrt{\mathrm{Hz}}}\right)$ | 0.0002 |

| Rate | $\left(\mathrm{Hz}\right)$ | 200 |

图6 传感器参考坐标系(蓝色为激光雷达,黄色为摄像头,红色为 IMU)

表6 传感器之间的相对变换关系

| 帧ID | 子帧ID | x(m) | y(m) | z(m) | $q_x$ | $q_y$ | $q_x$ | $q_w$ |

|---|---|---|---|---|---|---|---|---|

| cam1 | cam0 | −0.619 | −0.003 | −0.023 | −0.003 | −0.003 | 0.001 | 0.999 |

| cam0 | IMU | 0.248 | 0.021 | -0.405 | -0.002 | 0.701 | 0.713 | -0.003 |

| cam1 | IMU | -0.368 | 0.015 | -0.427 | -0.006 | 0.703 | 0.711 | -0.001 |

| IMU | LIDAR | -0.31 | 0.02 | -0.40 | 1.0 | 0.0 | 0.0 | 0.0 |

5.2|ROSbags

在ROS中,每个话题根据与其相关联的服务(或设备)的类型处理不同的消息(包含数据)。rosbag软件包允许将这些话题和消息记录在一个唯一的文件中,可以批量执行以重现实验。表7描述了收集的数据、消息类型和在该数据集中可用的话题。值得注意的是,包含IMU消息的话题/gps/duro/imu不包括方向,只包括加速度和角速度。方向是由IMU固件计算并发布在以下话题上:/gps/duro/rollpitchyaw、/gps/duro/current_pose和/gps/duro/odom。

为了使参考系统与激光雷达保持一致,应用了以下变换:

fim.linear_acceleration.x = − im.linear_acceleration.y,

fim.linear_acceleration.y = − im.linear_acceleration.x,

fim.linear_acceleration.z = im.linear_acceleration.z,

fim.angular_velocity.x = im.angular_velocity.y,

fim.angular_velocity.y = im.angular_velocity.x,

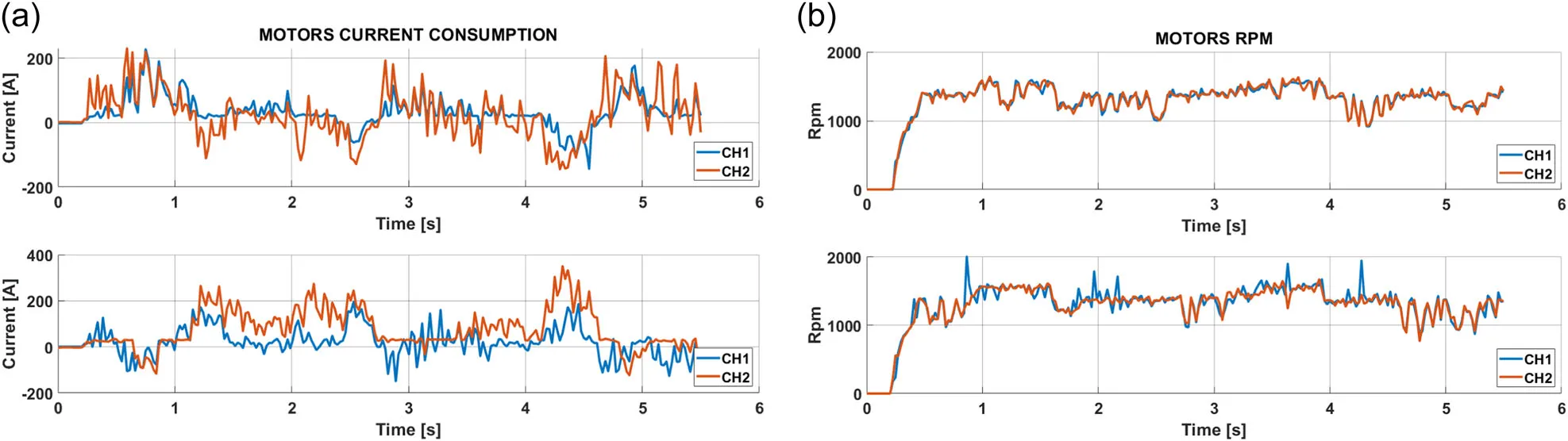

fim.angular_velocity.z = − im.angular_velocity.z,其中 fim 是fixed_imu_msg,im 是imu_msg。话题 /agrobot/Inverter/HBL2360A_* 提供由两个逆变器收集和处理的诊断信息。数据包括其状态(故障、故障标志和电路板温度)和电机测量值(RPM 和电流吸收)。每个逆变器使用两个通道(标记为“CH1”和“CH2”)驱动两个电动发动机(左侧和右侧):主题名称及其消息反映了这种配置。作为示例,图 7 显示了电机的一些诊断数据:短测试序列的电流吸收和每分钟转数。

表7 数据集提供的 rosbags 的话题、消息及其描述

| 话题 | 消息类型 | 描述 |

|---|---|---|

| /flir_adk/front/left/image_raw | sensor_msgs/Image | 来自前置 FLIR 摄像头的原始图像 |

| /flir_adk/front/right/image_raw | ||

| /gps/duro/current_pose | geometry_msgs/PoseStamped | (x,y,z) 坐标位置和方向(四元数) |

| /gps/duro/fix | sensor_msgs/NavSatFix | GPS 纬度/经度(带方差) |

| /gps/duro/imu | sensor_msgs/Imu | 绕 (x,y,z) 轴的角速度和加速度 |

| /gps/duro/mag | sensor_msgs/MagneticField | 3D 罗盘测量的磁场方向 |

| /gps/duro/odom | nav_msgs/Odometry | 相对于参考系的位置和速度的估计 |

| /gps/duro/rollpitchyaw | geometry_msgs/Vector3 | 方向 |

| /velodyne_points | sensor_msgs/PointCloud2 | 转换到原始参考系中的Velodyne 激光雷达点云 |

| /agrobot/Inverter/HBL2360A_L | diagnostic_msgs/DiagnosticArray | 来自逆变器的诊断消息 |

| /agrobot/Inverter/HBL2360A_R |

图7 从持续时间约为 6 秒的测试序列中提取的数据:图像(a,b)分别显示左侧和右侧电机的电流消耗和 RPM。 CH,频道; RPM,每分钟转数

5.3|Micasense MX 数据

在每次实验会话之前,进行辐射校准以补偿传感器的黑电平、灵敏度、增益和曝光设置以及镜头暗角效应。辐射模型用于将像素值归一化到0-1范围:将像素的原始数字除以2的N次方,其中N是图像中的位数。相机能够获取12位和16位的图像:在提出的数据集中,我们选择了16位,因此N=65,536。根据Micasense MX文档,这种归一化适用于像素和黑电平值。

图8展示了在葡萄园的实验会话期间收集的一个样本,包含了一批五张图像。每个图像都有其元数据,可以用于获取额外的信息,包括校准信息(辐射参数),拍摄参数(ISO速度、焦点、焦距和曝光时间),位置(GPS测量值)和方向(横滚、俯仰和偏航角)。

图8 这是在葡萄园采集过程中,由Micasense MX同时捕捉的不同光波长的图像集合。(a) 蓝色(475 nm),(b) 绿色(560 nm),(c) 红色(668 nm),(d) 近红外(842 nm),以及 (e) 红边(717 nm)

值得强调的是,多光谱相机的图像与其他数据不同步。然而,与图像相关联的元数据提供了GPS和时间戳信息,可以用于将其与其他传感器进行对齐。由于根据需求可能存在不同的对齐策略,我们选择保留传感器提供的多光谱图像,使用户可以根据需要自行实现后处理和对齐过程。

5.4|图像序列后处理

由于电压波动、冲击、网络拥堵和ROS节点通信错误,我们在原始RGB图像集中遇到了虚假和损坏的帧。为了生成一个高质量的数据集,采集的视频序列经过逐帧自动检查,以确保其完整性并保证帧之间的时间间隔相等。结果是,经过后处理的序列中的图像流不含有损坏的数据,并且帧速率在8-10 FPS的范围内。

6|应用

ARD-VO是一个多功能的数据集,可用于从移动机器人到农作物监测等不同研究领域。在本节中,我们展示了两个用例,重点展示了ARD-VO数据集的实用性。在第一个用例中,使用记录的序列来评估农业场景中机器人定位算法的性能。在第二个应用研究中,利用Micasense RedEdge-MX多光谱相机收集的多光谱图像和GPS位置信息用于计算NDVI(归一化植被指数)地图。

6.1|机器人姿态估计

ARD-VO数据集代表了一个具有挑战性的场景,用于测试姿态估计算法的鲁棒性,因为其中存在一些非理想条件,例如重复纹理、光照变化或机器人的非平滑运动。

本节讨论了比较不同姿态估计算法所获得的结果。为此,我们从最受欢迎的基于视觉的(参见Legittimo等人,2023年)和基于激光雷达的(参见Huang等人,2022年;Jonnavithula等人,2021年)姿态估计方法中选择了一组方法。具体而言,我们考虑了以下几种方法:

- Direct Sparse Odometry (DSO)(Engel等人,2017年)和 ORB-SLAM2 Mono(Mur-Artal和Tardós,2017年)用于单目相机测试;

- VINS-Mono(Qin等人,2018年)用于单目-惯性测试;

- ORB-SLAM2 Stereo(Mur-Artal和Tardós,2017年)用于双目相机测试;

- Open-VINS(Geneva等人,2020年)用于双目-惯性测试;

- FLOAM(Wang等人,2020年)和LeGO-LOAM(Shan和Englot,2018年)用于基于激光雷达的测试。

我们对八个序列进行了比较实验,每个种植领域选择了两个序列进行考虑。定量评估是基于由Swiftnav Duro设备提供的GPS-RTK测量获得的地面真实轨迹进行的。

在讨论结果之前,以下是对上述算法特点的简要总结。

6.1.1|基于视觉的姿态估计

基于视觉的姿态估计算法使用FLIR Blackfly相机捕获的图像,并对利用惯性测量的方法,使用由Swiftnav Duro模块提供的IMU读数。

- DSO(Engel等,2017年)从整个图像中采样像素,它基于对最近帧窗口内的光度误差进行连续优化。每个新帧最初都是相对于这些参考帧进行跟踪,然后根据情况被舍弃或接受以创建新的关键帧。

- ORB-SLAM2(Mur-Artal&Tardós,2017年)是一种适用于单目、立体和RGB-D设置的实时SLAM方法。它采用基于特征的方法对输入数据进行预处理,提取显著的关键点;具体而言,它基于有向FAST和旋转BRIEF(ORB)检测器(Rublee等,2011年)。三个并行线程同时工作:跟踪、局部建图和闭环检测。

- VINS-Mono(Qin等,2018年)是一种采用滑动窗口为基础的单目视觉惯性状态估计器。在基于纯视觉结构运动的初始化过程之后,该算法通过使用Kanade-Lucas-Tomasi(KLT)稀疏光流(Lucas&Kanade,1981年)来跟踪每个新图像的现有特征。为保持最少数量的特征,每个图像中都检测到Shi-Tomasi角点特征(Shi,1994年),最后选择关键帧。

- Open-VINS(Geneva等,2020年)是一种视觉惯性方法,其核心是融合惯性信息和稀疏视觉特征轨迹的扩展卡尔曼滤波器。这些视觉特征是使用加速段测试(FAST)算法(Rosten&Drummond,2006年)检测的,使用KLT(Lucas&Kanade,1981年)进行跟踪,最后利用多状态约束卡尔曼滤波器滑动窗口公式进行融合。

6.1.2|基于激光雷达的姿态估计

用于定位实验的第二组方法使用激光雷达扫描进行机器人定位和环境建图:

- Fast-LOAM(FLOAM)(Wang等,2020年)是一种计算效率高且准确的基于激光雷达的SLAM系统,它通过非迭代的两阶段畸变补偿方法扩展了先前的激光雷达测距与建图(LOAM)最先进策略,以降低计算成本。对于每个扫描输入,边缘特征和平面特征与局部边缘图和局部平面图进行匹配。然后考虑局部轨迹平滑性进行迭代姿态优化。

- LeGO-LOAM(Shan&Englot,2018年)是一种轻量级且地面优化的激光雷达测距和建图方法。它可以在低功耗嵌入式系统上提供实时的姿态估计。在第一阶段,该方法应用点云分割来过滤噪声。随后进行特征提取阶段,以得到独特的平面特征和边缘特征。该方法利用了分割和优化过程中的地面平面存在。

6.1.3|评价指标

所选的视觉里程计-视觉惯导(VO-VIO)方法通过三个不同的指标进行评估:姿态估计精度、相对于地面真实轨迹的估计轨迹比例以及相对于轨迹长度的误差率。由于算法依赖于一些非确定性操作,对同一序列进行多次运行可能会呈现不同的结果。因此,我们对每个算法进行了总共五次实验,并报告了每个指标的平均值和标准差。

姿态估计精度

我们使用evo3工具包来计算所选方法在提出的数据集上的姿态精度。该工具包允许处理、评估和比较里程计和SLAM算法的轨迹输出。在这项工作中,我们考虑绝对姿态误差(APE)的平移分量。更详细地说,可以通过逆组合算子计算此误差,该算子接受两个姿态并返回相对姿态(F. Lu&Milios,1997年):

$$ E_{i}=P_{e s t, i} \ominus P_{g t, i}=P_{g t, i}^{-1} P_{e s t, i} \in S E(3) $$

其中,$P_{e s t, i}, P_{g t, i}\in S E(3)$表示估计姿态和地面真实姿态在时间戳 i 处,⊖ 表示组合运算符。相关的绝对平移误差(ATE)定义为:

$$ \operatorname{ATE}_{t, i}=\left\|\operatorname{trans}\left(E_{i}\right)\right\| $$

最后,通过对所有(N)个序列姿态的 ATE 进行平均,计算出均方根误差(RMSE):

$$ \operatorname{RMSE}_{A T E}=\sqrt{\frac{1}{N} \sum_{i=1}^{N} A T E_{i}^{2}} $$

轨迹持续时间比

每当一个VO-VIO算法无法估计轨迹时,它可能停止提供姿态估计。这种行为严格与作者的实现相关,并且在不同的算法之间可能会有所不同。这一点必须考虑在内,因为APE值可能会具有误导性。因此,我们还考虑了另一个指标,即估计轨迹的时间持续比$\Delta t_{est}$与地面真实轨迹的时间持续比$\Delta t_{gt}$之间的比率。具体而言:

$$ R_{ts}=\frac{\Delta t_{est}}{\Delta t_{gt}}=\frac{ts_{end,est}-ts_{start,est}}{ts_{end,gt}-ts_{start,gt}} $$

其中,例如,$ts_{end,est}$是结果输出估计的最后时间戳,$ts_{start,est}$是地面真实轨迹的第一个时间戳。当算法成功预测轨迹时,$R_{ts}\approx1$。相反,当算法在序列开始时停止估计时,$R_{ts}\to 0$。因此,$R_{ts}$越接近1,这个指标就越表明失败率较低。

错误率

这个指标考虑了相对于估计序列长度的错误百分比。具体而言,这个错误比率的计算方式如下:

$$ R_e=\frac{RMSE_{ATE}*100}{R_{ts}*L} $$

其中,L是序列的总长度,而$R_{ts}*L$考虑了算法预测的序列部分。

故障率

最后,由于进行了多次运行,我们还考虑了失败比率。如果算法失败并且没有返回任何估计结果,或者如果估计的轨迹长度小于地面真实轨迹的10%,则将认为实验失败。该比率是基于5次运行计算的,如下所示:

$$ F=\frac{N}{5} $$

其中,N是失败的运行次数(例如,如果五次运行中有一次失败,则失败比率为0.2)。

6.1.4|结果与讨论

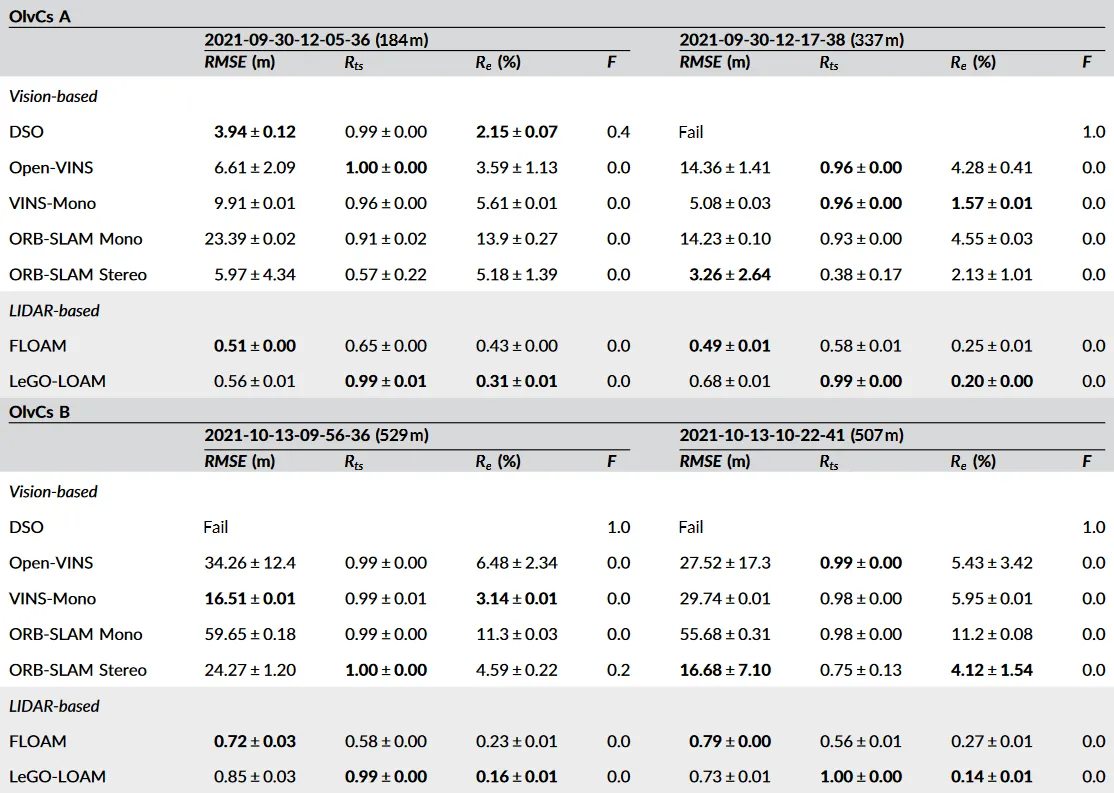

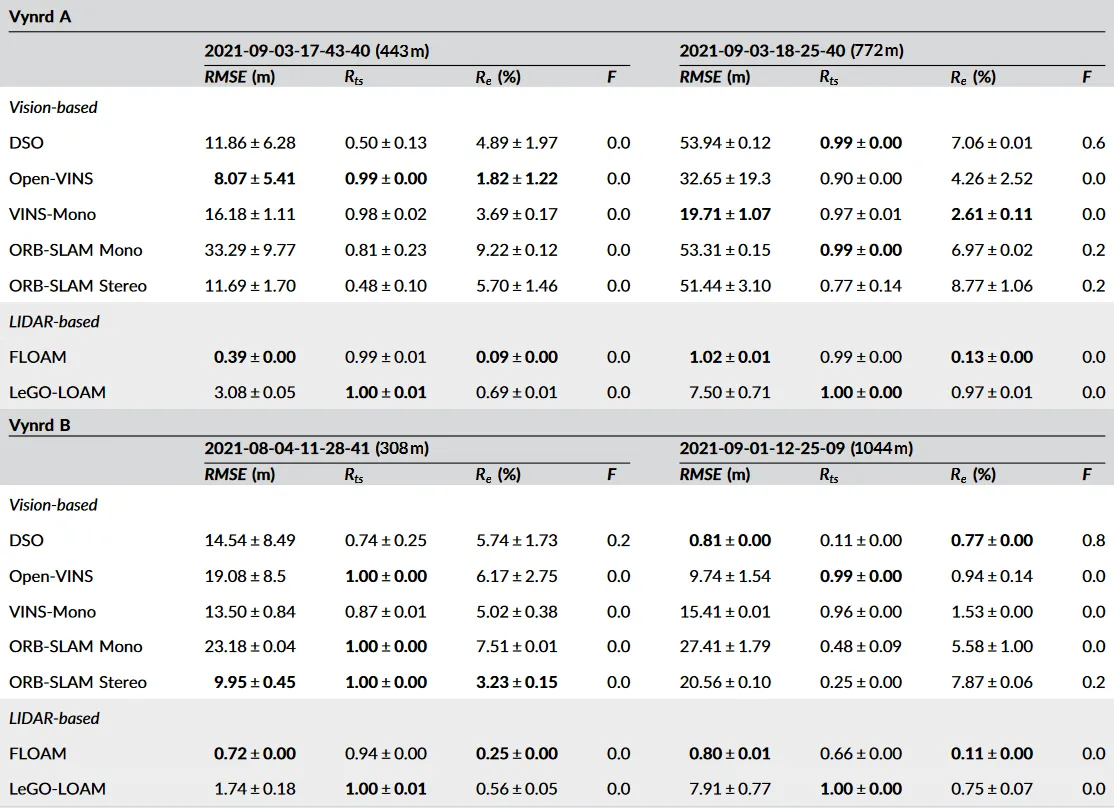

表8 所选测试序列的定量结果

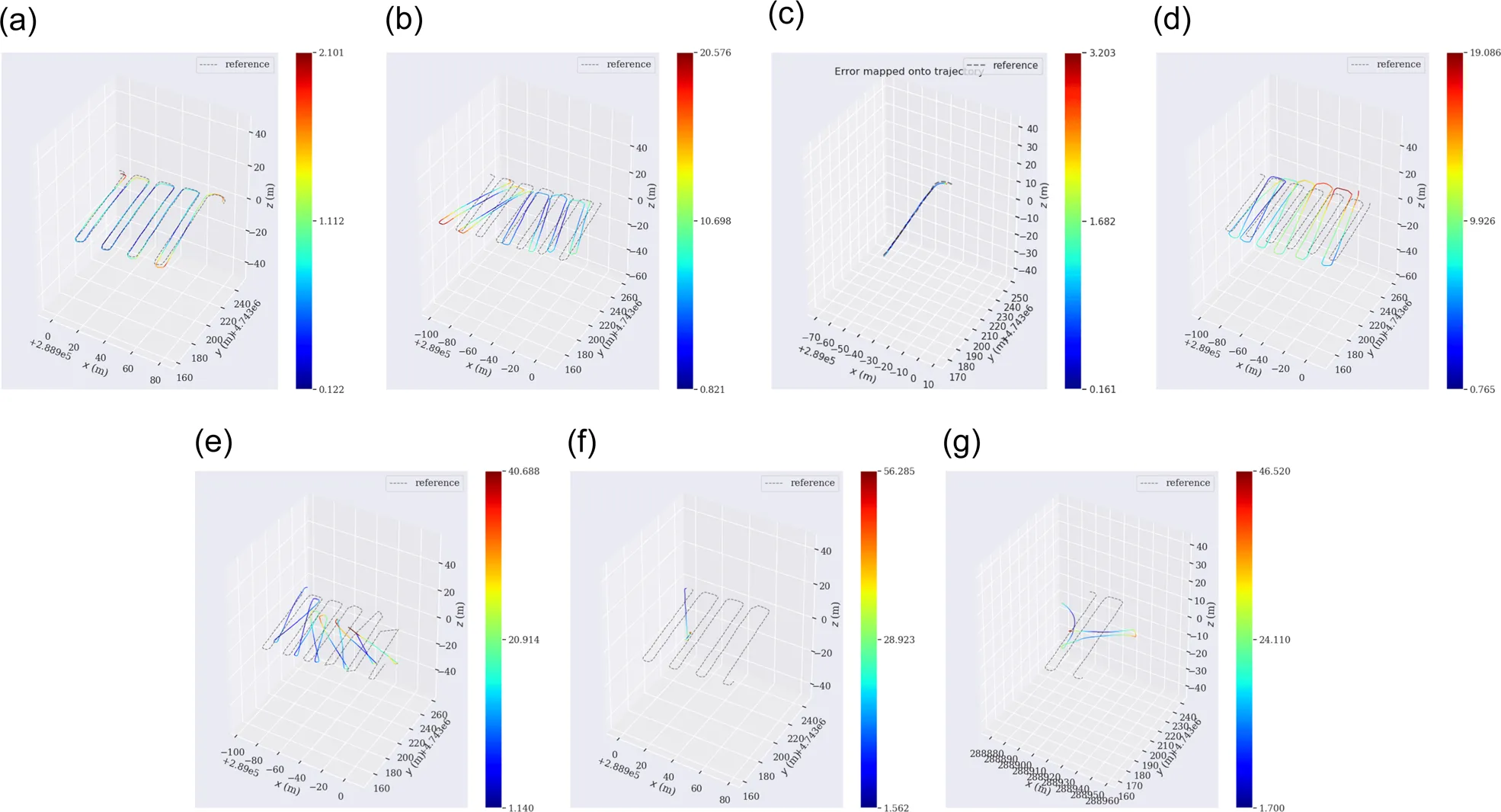

图9 在Vynrd B(2021年9月1日12:25:09)上的轨迹估计。一些方法可能会在轨迹结束之前失去跟踪或失败。在这些情况下,算法的执行被停止,并且不再提供估计的姿态。在这些情况下,对应的绘图显示较短的轨迹,因为仅显示了算法失败之前的估计姿态(以及相关的地面真实姿态),丢弃了其余的地面真实轨迹点。(a)FLOAM,(b)LeGO-LOAM,(c)DSO,(d)Open-VINS,(e)VINS-Mono,(f)ORB-SLAM Mono,(g)ORB-SLAM

在表8中,报告了不同实验的提议指标的定量数值,而在图9中展示了一组轨迹估计示例。结果显示,基于激光雷达的算法在预测序列轨迹方面表现出色,并且符合预期地优于所有基于视觉的方法。总体而言,FLOAM在平移误差方面具有非常高的性能,但容易失去跟踪。相反,LeGO-LOAM则展现出更高的鲁棒性,并保证了较低的估计误差。

在基于视觉的方法中,表现最好的是VINS-Mono和Open-VINS。然而,Open-VINS的标准差非常高,这表明非确定性操作对其性能有重要影响。ORB-SLAM Mono在RMSE方面的表现比其立体版本差,尽管后者通常具有较低的轨迹持续比(即$R_{ts}$)。相反,DSO是遇到更多失败的方法。

值得一提的是,所有基于视觉的方法都受到了大弯曲的影响:这是由于累积的漂移误差导致估计出更大的曲率。这是使得所提出的数据集具有趣味性的另一个方面,因为它代表了一个具有挑战性的场景,用于测试VO-VIO方法的鲁棒性。

6.2|NDVI地图

在第二个案例研究中,使用ARD-VO数据集的多光谱图像计算了地理参考的NDVI地图。NDVI是一个简单的图形指标,表示植物叶绿素的含量,用于估计遥感区域中的活体绿色植被。它可以使用以下公式计算:

$$ NDVI=\frac{NIR-Red}{NIR+Red} $$

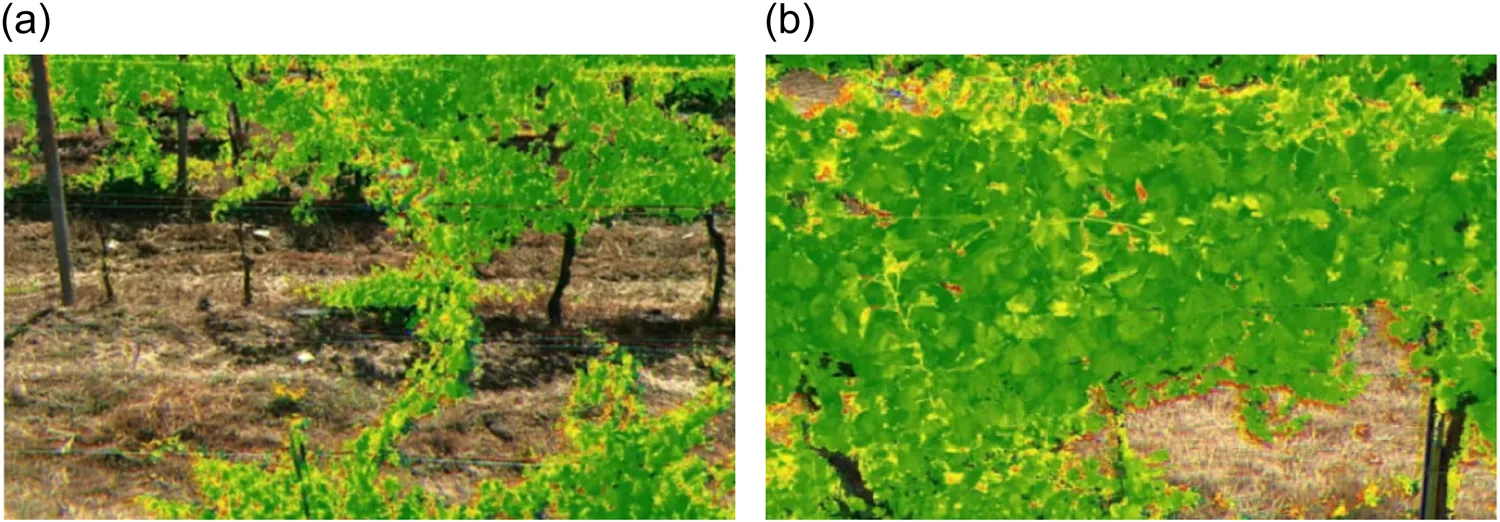

其中,Red和NIR分别表示在红外可见光和近红外区域获得的光谱反射率测量。高水平的NDVI表示作物健康,而低水平的指数可能是由于水分胁迫、疾病或害虫引起的。为了计算地图,我们考虑每个相机采集步骤生成的五个图像。这些图像涉及不同的光谱波段,即可见光中的三个波段(红色、绿色和蓝色),红外和近红外各一个。对于每个相机采集,使用传感器的GPS模块估计全局位置。后处理过程将帧组合成多波段图像,并计算每个像素的NDVI值。图10中展示了处理后的多波段图像示例。与样本关联的GPS位置的NDVI值通过对超过固定阈值的像素级NDVI进行平均计算。这些NDVI值可以组合成地理参考地图,用于农作物健康监测和安排进一步的干预措施。

图10 多光谱处理图像示例。可见光红色、绿色和蓝色通道与NDVI水平超过固定阈值的像素重叠显示

6.2.1|讨论

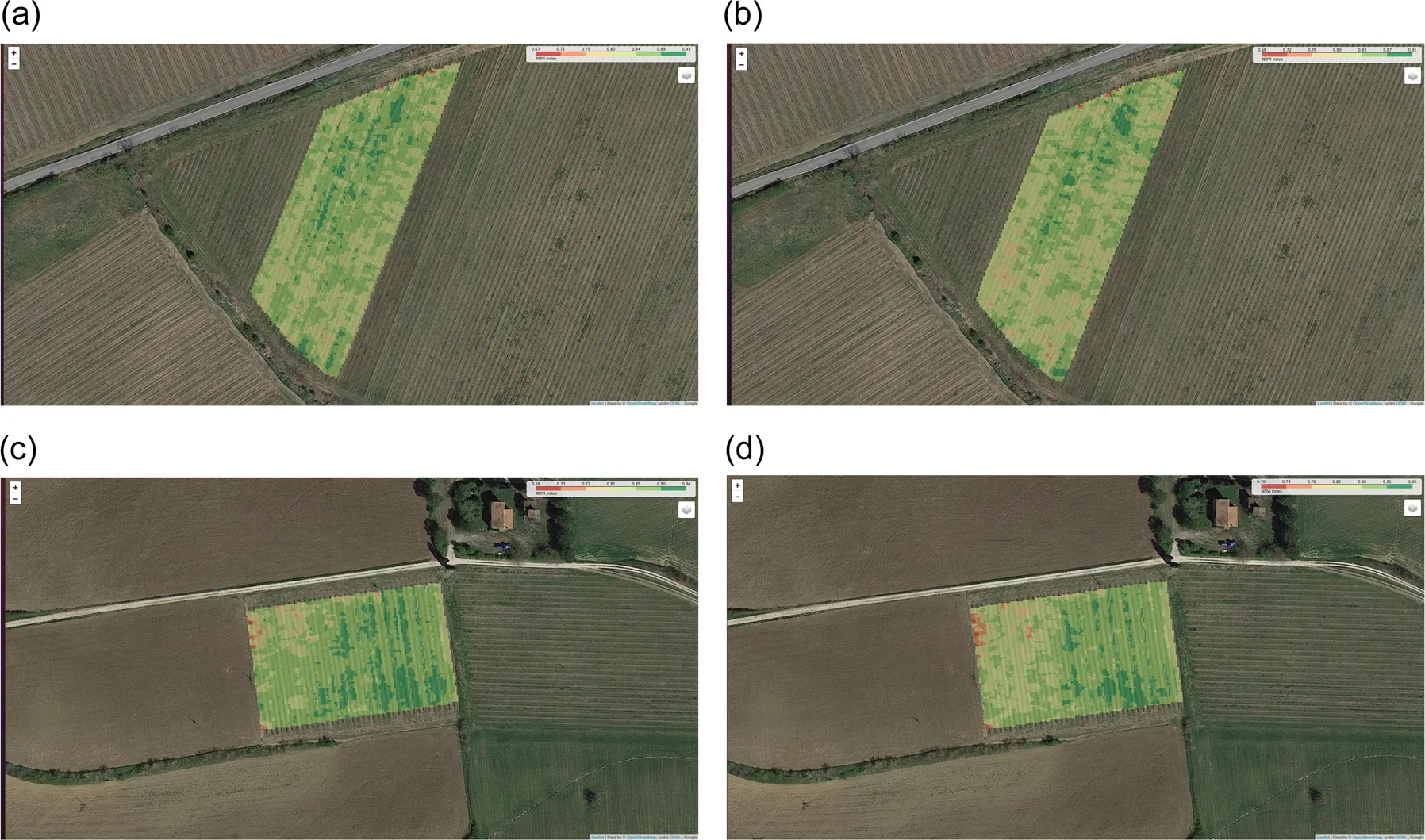

图11 使用Micasense RedEdge-MX多光谱相机收集的图像和GPS位置获取的地理参考NDVI地图。分别为Vynrd A果园(a,b)和Vynrd B果园(c,d)获取地图。(a)Vynrd A—2021年8月3日,(b)Vynrd A—2021年9月3日,(c)Vynrd B—2021年8月4日,和(d)Vynrd B—2021年9月1日

在图11中展示了计算的Vynrd A和Vynrd B作物地图的示例,以热力图的形式呈现。地图的每个像素表示从该点收集的图像计算得出的平均NDVI值。在每个地图中,我们观察到一个高活力区域,其特征是NDVI指数较高(深绿色),一般表示植物健康茂盛。中等和低活力区域的特征是较低的NDVI值(分别为黄色和红色),通常是由年轻植物的存在或水分胁迫状态引起的。值得注意的是,在2021年8月(图11a、c)和2021年9月(图11b、d)期间计算的地图中,NDVI值有所下降,主要是由于这两个数据收集会话之间的高温和降水量较低的影响。

7|结论

在这项工作中,我们描述并向社区提供了一种新的用于农业场景的机器人应用数据集,即ARD-VO。该数据集是在葡萄园和橄榄园中收集的,包括通过在四个不同的种植领域中的UGV上导航收集的异构数据序列。

在论文的第一部分,我们提供了机器人平台和用于数据收集的传感器的技术特性的描述。此外,我们详细介绍了数据集的采集过程、结构和特点。

通过两个应用研究来说明数据集的实用性,即在农村环境中的机器人定位和建图,以及使用多光谱成像和NDVI地图进行植物健康监测。具体而言,我们使用所提出的数据集的序列对最先进的SLAM和VO估计方法进行了性能比较,这些方法使用了视觉、激光雷达和惯性数据。此外,我们还介绍了一种计算NDVI地图的过程,该过程利用Micasense RedEdge-MX相机收集的多光谱图像和GPS测量数据,计算出一个地理参考地图,用于编码监测种植领域中植物健康状况的信息。

7.1|局限性和未来的挑战

如前面的章节所展示的,所提出的数据集可以用作橄榄园和葡萄园环境中自主导航和数据分析算法的基准,以促进相关应用的发展。然而,我们进行的数据采集活动揭示了整体采集系统的一些限制和开放性挑战,这可能会激发未来的研究工作。

首先,我们使用的Agrobot平台从“地面视角”收集周围环境的信息。虽然这使得我们能够观察到橄榄或葡萄的细节,但无法收集到种植物的上部信息,也无法获取到完整树木的激光扫描和单幅图像。将地面平台与空中机器人(例如微型空中车辆)结合起来可能可以弥补这个限制,并提供从不同视角获得作物信息的数据集。这将使我们既能获得单个水果的细节,又能够以鸟瞰视角观察到一组树木或一排葡萄藤。

使用地面机器人还限制了我们对感兴趣的种植领域的尺寸。这既受到电池自主性的限制,也受到平台速度的限制,这两者限制了在单个电池循环中行驶的距离。为了解决这个问题,除了MAV之外,多个地面平台的多机器人设置可能是一个可行的选择。不同的机器人可以协调工作,以最大程度地覆盖种植领域,同时优化能源资源和采集时间。然而,设计这些解决方案时应考虑到需要同步每个单元收集的数据所带来的额外复杂性。

虽然在提出的数据集中提供了橄榄的生长阶段、葡萄园的生产特征和植物-生产平衡指数等不同信息,但还有其他重要的细节可以有助于促进农业分析。这些细节包括(i)植物的其他物候特征,(ii)湿度或氮含量等信息,以及(iii)可能存在的疾病。未来的工作将集成额外的设备,例如湿度传感器、更多的多光谱相机和热成像相机,确保它们与其他数据和整体采集系统紧密同步。此外,将记录和关联植物的健康状况和特征与数据序列。

最后,在采集会话期间,存储设备测量所需的存储空间随着种植领域的规模增长,并随着系统添加更多传感器而增加。为了解决这个问题,平台的机载计算单元可以配备在线数据处理程序,从原始数据中提取感兴趣的信息。

致谢

这项工作得到了“PSR Umbria 2014/2020,Misura 16.2”倡议框架内的“Gruppo Operativo Agrobot”项目的支持。作者承认 Cratia SRL(Confagricoltura Umbria)在项目管理中的作用以及以下机构的合作:佩鲁贾大学工程系和农业、食品和环境科学系;佩鲁贾农业研究所基金会;比萨圣安娜高等研究院生命科学研究所; “Ciuffelli Einaudi” 托迪农业技术学院 (PG); Assoprol 翁布里亚和 Infomobility SRL 摩德纳。开放获取资金由佩鲁贾大学根据 CRUI-CARE 协议提供。

数据可用性声明

ARDVO 数据集可在 https://isar.unipg.it/datasets/ 上获取。其他信息和代码可在以下存储库中找到:https://github.com/isarlab-department-engineering/ARDVO。

参考文献

略